Adobe presentó ayer una novedad llamada "Relleno Generativo" en versión beta para Photoshop que es una absoluta locura. Todo parte de su proyecto Firefly, un motor que utiliza IA para generar imágenes, sólo que ahora estará integrado dentro de la propia interfaz de su popular aplicación de diseño gráfico - lo cual pone a disposición de prácticamente cualquiera la capacidad de editar imágenes con inteligencia artificial.

Sólo está disponible en versión beta dentro de los canales de descarga de su suite de aplicaciones, Creative Cloud, pero la potencia y lo que se puede hacer con ella es asombroso.

Qué hacer si no te funciona la IA Generativa

Ojo que si no tenéis vuestra fecha de nacimiento en Behance no podréis usar esta nueva funcionalidad

Ojo que si no tenéis vuestra fecha de nacimiento en Behance no podréis usar esta nueva funcionalidad

Cuando probé por primera vez la versión de Photoshop Beta, no aparecía la opción de la nueva barra flotante donde podemos introducir los "prompt" de las imágenes que queremos generar. Si os ocurre esto, tratad de actualizar de nuevo la beta porque en ocasiones no se descarga la versión correcta a la primera.

Si lo descargáis, y no se activa el botón de "Generative fill" es por dos motivos: el más raro es porque quizás no tengáis acceso a internet (que es requisito para esta nueva funcionalidad, ya que nada se procesa en local). Lo más habitual es que necesitéis tener vuestra fecha de nacimiento en el perfil de Adobe. Lo complicado es encontrar donde se añade, ya que no es tan sencillo.

Contacté con los técnicos de Adobe para informarme de este problema y la solución está algo escondida: debéis ir a la sección de "Vínculos a recursos" dentro de Creative Cloud y luego pulsar en Behance. Esto os abrirá un navegador donde podéis poner vuestra fecha de nacimiento que quedará guardada en vuestra cuenta - y se os activará la opción.

Los primeros experimentos son prometedores

Todas las pruebas están hechas en un MacBook Pro M2 Max, aunque eso realmente es indiferente para ellas: el tiempo de procesado es realmente la velocidad de carga y descarga de internet que tengamos en nuestra conexión, ya que la parte de la imagen a procesar se envía y se recibe on-line. Suele ser cuestión de segundos (unos 10-12) en una conexión de 300Mbps como la mía, dependiendo de la zona a tratar y la complejidad del prompt.

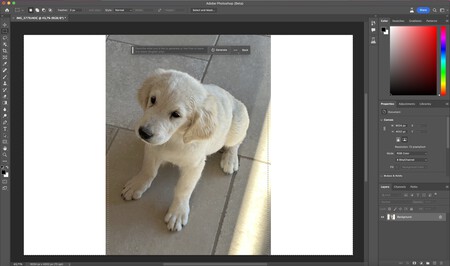

No os enamoréis, pero este perrito de un familiar se llama Romeo

No os enamoréis, pero este perrito de un familiar se llama Romeo

Empezamos con las pruebas, escojo una imagen de un perrito de un familiar que hice con el iPhone, en formato vertical. Primero, amplio el lienzo para tener algo de espacio. Mi idea es convertir, por ejemplo, esta foto pensada para una historia de Instagram, en una foto horizontal. Selecciono las zonas blancas ampliadas que quiero rellenar, pero no indico que quiero en ellas: la IA se encargará de ampliar los límites de la imagen automáticamente.

Como veis, el resultado es espectacular. Siempre nos ofrece tres versiones, que podemos elegir con el navegador derecho. Ahora voy a poner algo de color, añado hierba a una esquina, a ver si cubre bien el área, cuadra con la iluminación y el contorno de las losetas: en el prompt, simplemente escribo "Grass" (de momento la versión beta sólo entiende comandos en inglés):

Como veis la composición es perfecta y en la zona de las capas, cada elemento generado por IA tendrá la suya propia: para podamos ocultarla o borrarla en cualquier momento. Añadamos ahora algunos juguetes perrunos.

Escojo, de las tres opciones, el menos "raro", pero como veis queda perfecto en tamaño y perspectiva, arriba a la derecha. Yo no retoco nada manualmente: todo lo que veis lo genera al instante la IA. Pasemos a una zona complicada: la de los rayos de sol de la derecha. Y pidámosle algo más complejo: comida de perro en un plato, en la zona de sol:

El juguete perruno de arriba a la izquierda también ha sido generado por IA.

El juguete perruno de arriba a la izquierda también ha sido generado por IA.

Fijaos que perfección a la hora de iluminar el plato, la comida... cuadra con los rayos de sol laterales y la perspectiva es perfecta. Ojo, esto es una pasada: sin decirle nada de la imagen, la IA interpreta la perspectiva y situación el elemento con su corrección y creada teniendo en cuenta los parámetros físicos como luz, inclinación, tamaño del resto de objetos de la escena... Para acabar, algo aún más difícil: añadamos una manta entre el perrito y el plato de comida, con los rayos de sol incidiendo:

El resultado, como veis, es absolutamente increíble. He tardado unos dos minutos de reloj en generar esa escena con una foto completamente normal de mi móvil - y con un contenido fotorealista. Veamos otro ejemplo, un plato de comida, tomado en modo retrato con el iPhone, por lo que tiene zonas desenfocadas, con luz, perspectiva...

Vamos a pedirle que ponga un trozo de pan, pero no a decirle ni el tamaño, ni como lo quiero ni donde. Selecciono el lateral del plato, y simplemente escribo "bread" en el prompt, sin más:

Los resultados en cuanto a calidad del elemento incorporado, iluminación, integridad con el resto de la foto... es rotundo. Tengo que decir que además Photoshop me presentó otras dos opciones con panes diferentes, uno integral y otro más tipo "bollito". Esto pasa porque no especifiqué que tipo de masa quería.

Ahora vayamos a una zona complicada, a la izquierda: intersección de luces y sombras, perspectiva, desenfoque de lente... vamos a pedirle que añada un mando a distancia, genérico:

Como veis, lo borda. Y además sin regenerar ni una sola vez: es la versión que la IA me ofrece por defecto, aunque habían dos modelos más. Con esta tecnología también podemos borrar cosas de la imagen: sin ajustar mucho, simplemente seleciono el tenedor y el cuchillo y escribo en el prompt "borra tenedor y cuchillo":

El helado también ha sido generado por IA

El helado también ha sido generado por IA

Un segundo después, aquí tenéis el resultado. Podemos añadir ahora elementos encima, seguir borrando, cambiar el color del mantel o ampliar los límites de la imagen, como hemos visto con la prueba del perrito.

Una tecnología que será mainstream

Foto original

Foto original

Lo que ofrece Photoshop con esta nueva integración de relleno generativo son las herramientas básicas de manipulación de imagen que cualquiera puede usar: no hay que entrenar ningún modelo, ni tener un Mac potente. Solo tienes que decirle lo que quieres, y lo hace. Siempre con límites: en mis pruebas, la generación de seres vivos deja mucho que desear y algunas generaciones algo más complejas hay que trabajarlas más a nivel de prompt o luego retocándolas desde el programa.

Como último ejemplo, de nuevo ampliar los límites de una imagen vertical: simplemente ampliando el lienzo y dejando rienda suelta a Photoshop, nos lo convierte no sólo en una imagen creíble sino consistente con la escena - en segundos.

Foto con límites ampliados, automáticamente generada por la IA de Photoshop en 12 segundos.

Foto con límites ampliados, automáticamente generada por la IA de Photoshop en 12 segundos.

Mientras llega la versión final de Photoshop con las capacidades Firefly integradas, ya podemos decir que la edición de imágenes por IA no está sólo a disposición de unos pocos: es uno de los programas de edición más famosos del mundo los que lo integran, y va a empezar a llegar a cualquiera. Veamos que es lo que ofrecen en el futuro y qué alternativas plantean - sin duda - sus competidores en los próximos meses. Si no lo pruebo, no lo creo.

En Applesfera | Microsoft ya tiene su revolución, ahora es el turno de Apple: quiero una IA como Copilot en Mac y creo que está cerca

Ver 10 comentarios

10 comentarios

membri33

malas noticias para la versión 🏴☠️

Eusebio

Coincido totalmente contigo @pedroaznar. Hoy he estado jugando con la beta y me duele la boca de tenerla abierta. Alucinante como trabaja incluso con imágenes con poca resolución. Es una bestia para editar, añadir elementos, eliminarlos, ampliar lienzo.... y estamos ¡en la beta!

Probar a seleccionar un rostro y pedirle un cambio en la expresión. ¡Boooom!

Adobe ha dado un golpe en la mesa haciendo un uso de la IA, elegante, potentísimo y totalmente integrado en la app sin parecer un pegote "extra" puesto a calzador. Nos esperan años de vértigo con esto de la IA.

rorik

Esto es buenisimo, yo uso el photoshop para cuestiones no tan avanzadas; la integración de elementos siempre ha sido de lo que más se me complica realizar, así que estos prompts me vienen de maravilla para mi nivel de conocimientos en la herramienta y de diseño

Coloro

creatik

Como diseñador gráfico profesional, y manejando Photoshop desde hace mas de 25 años, esto me deja alucinado. Ese tipo de retoques solo los podria hacer una persona con muchos conocimientos, mucha vision y varias horas de trabajo... sin contar el buscar las imagenes para insertar etc...

Me da pena por los trabajos que se perderan, pero es el futuro, imparable.

jtaulats

Solo una observación: como veis, mucha de la creatividad está en los "prompts" que demos a Photoshop, no en la propia IA. Por supuesto es una ayuda de maravilla.

McEro

Me pasé a Affinity cuando empezaron a cobrar una suscripción por poder usar un programa instalado localmente y no lo hecho en falta para nada

aintzane_

¿Como hacéis para sacar la barra de los Prompts? Porque a mi esa opción no me aparece, no así como otras opciones que si entran en la actualización.